カラクリ、世界で初めてAWS TrainiumでMoEモデルを学習した「KARAKURI LM 8x7B Chat v0.1」を公開

開発費30万円、トレーニングコストの大幅削減を実現

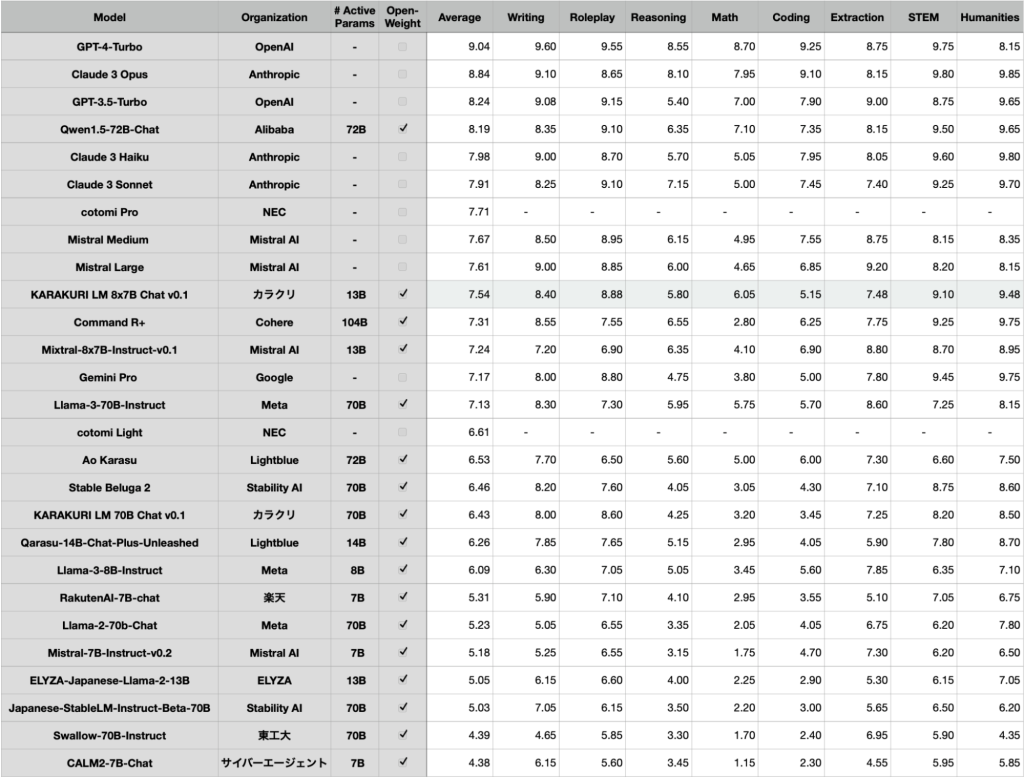

カスタマーサポートDXを推進するカラクリ株式会社(東京都中央区:代表取締役CEO 小田志門、以下カラクリ)は、アマゾン ウェブ サービス ジャパン合同会社(以下、AWSジャパン)の「AWS LLM 開発支援プログラム」を活用し、世界で初めて※1AWS TrainiumでMoEモデル※2の学習に成功いたしました。総パラメータ数467億、推論時のアクティブパラメータ数129億の大規模言語モデル(以下、LLM)「KARAKURI LM 8x7B Chat v0.1」はベンチマークテストで国産オープンモデルとして最高点の評価を得ており※3、2024年5月7日に一般公開いたしました。世界的にGPU不足が深刻化する中で、AWS TrainiumでMoEモデルの学習を成功したことは、生成AIの社会実装の大きな一歩につながると考えております。またAWS Trainiumは、同等のGPUインスタンスと比較して、トレーニングに要するコストを最大50%削減できるといわれており、今回のモデルの開発費用は30万円と低コストでの開発に成功しております。

※1.カラクリ社調べ(2024年5月時点・オープンソースおよびインターネットで情報公開されているLLMとして)

※2.MoEモデルはGPT-4などでも採用されていると言われている方式で、複数の専門家(エキスパート)とそれらの専門家の意見を組み合わせる方法を表す機械学習モデルです。複雑なデータや問題に対して高い精度を達成することができ、総パラメータ数を増やしつつ、それに伴う計算量の増加を抑えることができることから、LLMが巨大化していく中で必須と言われています。

※3. 「Japanese MT-Bench」の性能評価で、国産オープンモデルとして最高点の評価を得ております(2024年5月7日時点)

【開発背景】

GPUに依存せず、生成AIの発展を促進

生成AIブームにより、需要と供給のバランスが崩れ、2023年春頃から世界的にGPU不足が顕在化しています。特に枯渇しているのがエヌビディア社の高性能GPUであり、AI開発における最大のボトルネックとなっているといっても過言ではありません。生成AIの社会実装を加速させるために、エヌビディア社のGPU以外のAIアクセラレーターを模索する重要性を感じ、研究・開発を進めていったことが今回の結果へと結びつきました。

【KARAKURI LM 8x7B Chat v0.1について】

カラクリは2023年9月に「AWS LLM 開発支援プログラム」に採択いただき、700億パラメーター「KARAKURI LM 70B Chat v0.1」の開発に着手、2024年1月に国産オープンモデルとして最高性能を獲得いたしました。その後、LLMの主流となっているMoE方式を採用し、「KARAKURI LM 8x7B Chat v0.1」を開発。本モデルも、「Japanese MT-Bench」の性能評価で、国産オープンモデルとして最高点の評価を得ております(2024年5月7日時点)。

■特徴

金融・医療業界でのモデル構築の活用を見込む

「KARAKURI LM 8x7B Chat v0.1」が、今回の開発にかかったコストは、金額にして約30万円、学習時間は12時間に抑えることができました。AIのビジネス活用において、コストは大きな課題となっております。数十万円という価格での学習が現実的になったことで、企業毎の学習データにあわせたLLM開発が現実的なものになっております。これにより、セキュリティやカスタマイズを重視される医療・金融機関などの活用が見込めます。

■公開URL

https://huggingface.co/karakuri-ai/karakuri-lm-8x7b-chat-v0.1

デモ

※期間限定で公開しており、上記デモは予告なく終了する可能性がございますので予めご了承ください。

【世界で初めてAWS TrainiumでMoEモデルを学習させた技術について】

KARAKURI techblogでは、使用した技術の詳細記事を投稿しておりますのでご覧ください。

KARAKURI techblog:https://medium.com/karakuri/train-moes-on-aws-trainium-a0ebb599fbda

コード:https://github.com/karakuri-ai/neuronx-nemo-megatron

【KARAKURI LMについて】

モデルの詳細については前回のプレスリリース「カラクリの700億パラメーターLLM、国産モデルの中で最高性能を獲得」をご参照ください。本モデルは前回の発表したLLMを公開可能な形に修正し、改めて性能評価を実施しております。

KARAKURI LM概要について:https://ad.karakuri.ai/karakuri-lm

▶ 会社概要

カラクリは「カスタマーサポートをエンパワーメントする」をブランドパーパスに掲げ、大規模言語モデル(LLM)のカスタマーサポートへの実用化を目指した事業を展開しています。2018 年より transformer を用いた言語モデルBERT を、2022 年からは GPT を含めた大規模言語モデルの研究を実施。主力ビジネスである高精度 AI チャットボット「KARAKURI chatbot」は、高島屋、SBI 証券、セブン-イレブン・ジャパン、SmartHR など各業界のトップランナーに選ばれつづけています。2018 年の ICC サミット「スタートアップ・カタパルト」に入賞、2020 年に「Google for Startups Accelerator」に採択、2023 年に「AWS LLM 開発支援プログラム」に採択されました。

| 住所 | 〒104-0045 東京都中央区築地2-7-3 Camel 築地 II |

| 設立 | 2016年10月3日 |

| 代表者 | 代表取締役CEO 小田 志門 |

| 事業内容 | カスタマーサポート特化型AI「KARAKURI」シリーズの開発・提供・運営など |

| URL | https://about.karakuri.ai/ |

▶ 本件に関するお問い合わせ先

カラクリ株式会社: 広報 堀之内

E-mail: pr@karakuri.ai